中 |

行人检测作为计算机视觉L域基本的主题之一,多年来被广泛研究。尽管先进的行人检测器已在无遮挡行人上取得了超过 90% 的准确率,但在严重遮挡行人检测上依然无法达到满意的效果。究其根源,主要存在以下两个难点:

严重遮挡的行人框大部分为背景,检测器难以将其与背景类别区分;

给定一个遮挡行人框,检测器无法得到可见区域的信息;

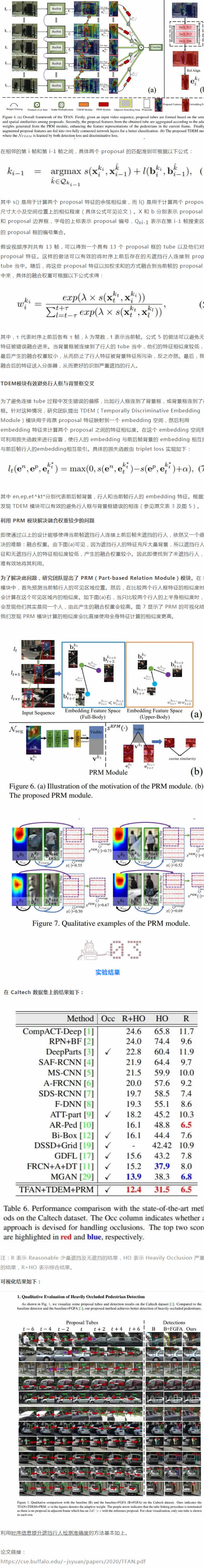

Tube Feature Aggregation Network(TFAN)新方法,即利用时序信息来辅助当前帧的遮挡行人检测,目前该方法已在 Caltech 和 NightOwls 两个数据集取得了业界L先的准确率。

核心思路

利用时序信息辅助当前帧遮挡行人检测

目前大部分行人检测工作都集中于静态图像检测,但在实际车路环境中大部分目标都处于运动状态。针对严重遮挡行人的复杂场景,单帧图像难以提供足够有效的信息。为了优化遮挡场景下行人的识别,地平线团队提出通过相邻帧寻找无遮挡或少遮挡目标,对当前图像中的遮挡行人识别进行辅助检测。

实验新方法

Proposal tube 解决严重遮挡行人检测

如下图,给定一个视频序列,先对每帧图像提取特征并使用 RPN(Region Proposal Network)网络生成 proposal 框。从当前帧的某个 proposal 框出发,依次在相邻帧的空间邻域内寻找相似的proposal框并连接成 proposal tube。

| 资料获取 | |

| 新闻资讯 | |

| == 资讯 == | |

| » 微触开关传感器-很简单的传感器,用程序就 | |

| » 为机器人安上转向灯:连接机器人,编写程序 | |

| » 简单机器人的主控制器与扩展板 | |

| » 医院导诊机器人部分案例 | |

| » 机器人中最为流行的驱动方式-双轮差速驱动 | |

| » 机器人对人类的帮助:代替人类完成体力劳动 | |

| » 机器人的四大组成部分:主控制器,传感器, | |

| » AI 革命进入新阶段,赋能全场景终端-从 | |

| » 具身智能商业化元年全洞察-政策密集出台, | |

| » 具身智能产业发展现状与趋势调研报告202 | |

| » 2025年保姆机器人行业发展趋势报告-四 | |

| » 2025年机器人产业的变革与展望白皮书- | |

| » 2025养老机器人行业研究报告-市场规模 | |

| » OpenAI的软硬件生态布局与进展-硬件 | |

| » 2025年通向AGI之路-全球人工智能展 | |

| == 机器人推荐 == | |

服务机器人(迎宾、讲解、导诊...) |

|

|

| 消毒机器人排名 移动消毒机器人 导览机器人 |