| 摩登7机器人 |

| CHUANGZE ROBOT |

目前跟踪“手眼脑”协同的操作流程,主要包括手眼位置标定、基于图像抓取位姿估计网络模型、触觉感知力反馈调节等技术难点。

1) 如何实时、准确跟踪末端执行器与被操作物体之间的空间距离和位置信息?手眼位 置标定是通过建立机器人末端执行器坐标系与相机坐标系之间转换关系,实现视觉引导 机器人操作的准确性和可靠性。根据机械臂与相机之间的装配方式,手眼标定分为Eye to-Hand和Eye-in-Hand。早期的手眼标定技术主要依靠矩阵关系(旋转矩阵和平移矩 阵)描述机器人和相机之间的空间关系。随着计算机视觉和优化算法的发展,基于图像 处理和数学优化的手眼标定方法逐渐成为主流,利用标定板或特征点进行相机标定,再 结合机器人末端执行器的位置数据进行标定计算,以实现准确的手眼标定。

Eye-in-Hand;相机固定在末端执行器,相机所摄取场景数据随着机械臂移动而发 生变化,适合对末端操作对象(比如零件)进行G精度局部观察,也可以灵活调整 视角,用于精密装配等应用。

Eye-to-Hand:相机固定安装在人形机器人某个位置(比如头部),d立于机械臂 运动。相机视角覆盖整个工作空间,可实现全局观测,适合监控机器人整体运动轨 迹或大范围场景,标定结果无需频繁更新。

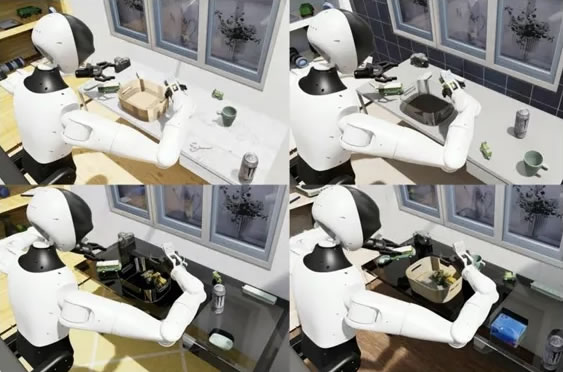

2) 如何正确选择跟交互物体的操作位姿?机器人抓取检测技术是机器人领域中的重要 研究方向之一,涉及到机器人在实际操作中获取Z优抓取姿态和位置的能力,从而实现 有效、稳定的抓取动作。抓取检测技术的发展可以分为传统的解析方法和基于深度学习 的方法。传统的解析法是基于机械手爪和目标物体的运动学和动力学关系进行建模,计 算Z优抓取位姿,适合非常准确场景控制需求,比如工业机器人对物体抓取和移动,但 受限于环境复杂性和泛化能力不足。传统方法往往需要复杂的模型和参数调整,无法实 现对各种场景和物体的智能适应。

随着人工智能和机器学习技术的不断发展,深度学习抓取策略持续导入。基于深度学习 的抓取技术通过深度神经网络对大量图像数据进行训练,从而学习抓取的正确位置和姿 态,具有更好的泛化能力和适应性。基于深度学习的抓取技术可以分为基于抓取候选框 和基于鲁棒性函数两类。

基于抓取候选框的方法主要采用滑窗的方法预先在输入图像上生成若干个感兴趣的区 域,通过卷积神经网络等模型提取图像特征,预测抓取位置和姿态。该方法检测精度较 G但因会产生大量的候选框而使得检测算法耗时较长。目前现存一些机器人抓取的任务 基准数据集可以用于抓取位置和姿态预测训练优化。比如康奈尔大学创建的Cornel Grasp数据集,即使用KinectV1相机在真实场景中采集,涉及240种生活中常见物体 的885张RGB-D图像和相应的三维云点。数据特征涵盖了多样的对象形状和大小及带 有旋转角度的抓取标注框。

基于鲁棒性函数的方法主要通过学习抓取质量函数,评估抓取质量,进而确定Z优抓取 位置和姿态。该方法实现端到端训练与预测,算法运行速度较快。典型地,智元机器人 发布开源仿真数据集AgiBotDigitalWoHdDataset,涵盖五大类场景、180+品类具体物 品等。平台基于NVDlA1saac-Sim仿真平合开发(Sim2Real),可以提供G度逼真的视 觉渲染和准确的物理模拟。仿真过程中,具身智能数据生成引擎可以进行丰富的环境光 照、物体材质、物理属性等随机变化,同时支持多种操作轨迹增强方式,以生成多样性 和鲁棒性的专家轨迹数据,增强模型泛化能力。目前AgiBotDigitalWord可建立贯穿 专家轨迹生成、模型训练、基准测试、部署验证的完整评估流程,支持对机器人的端到 端模型进行多面测试。

|

| 智能服务机器人 |